I. Initiation et comprĂŠhension▲

I-A. Un peu d'histoire▲

I-A-1. La paranoĂŻa en système de conduite d'entreprise▲

Google est une entreprise US paranoĂŻaque ne donnant aucune ou presque indication sur son fonctionnement technique.

Pourquoi ? Outre la thĂŠorie de Andy Groove (le fondateur de Intel) il faut se pencher sur la jeune histoire de la recherche d'informations sur le Net pour comprendre.

Les moteurs (Altavista essentiellement) dominent la recherche d'informations sur la première gÊnÊration du WEB commercial (jusqu'en 1998)

Ces moteurs donnent des rĂŠsultats de plus en plus approximatifs avec l'arrivĂŠe massive et exponentielle de sites web au fil du temps.

Les annuaires prennent le relais et balaient les moteurs en moins de un an (Yahoo !) en 1998/1999

Les rĂŠsultats de recherche via annuaires sont plus pertinents, les recherches plus faciles.

- Il faut payer ou ĂŞtre patient pour avoir son site indexĂŠ par l'annuaire Yahoo.

- Un petit site sans intĂŠrĂŞt bien rĂŠfĂŠrencĂŠ peut aisĂŠment sortir devant un site rĂŠellement pertinent lors de recherches

- Vous avez de l'argent ? vous serez bien rĂŠfĂŠrencĂŠ au final. Yahoo empoche et les internautes usagers sont flouĂŠs.

Bref, les annuaires reprÊsentent un progrès mais les quantitÊs impressionnantes de nouveaux sites arrivant chaque jour mettent en exergue les dÊfauts de qualitÊ des recherches via annuaires. 2001/2002 : le moteur Google balaie tout le monde - part de marchÊ > 98% en 2003 !!! Google offre de sÊrieux avantages sur les annuaires tels que Yahoo !

- C'est gratuit pour le rĂŠfĂŠrencement. Les mots clef sont payants, comme chez tout le monde (les autres moteurs et annuaires). Mais le rĂŠfĂŠrencement de qualitĂŠ et gratuit est accessible Ă tous. Que le meilleur gagne, car mĂŞme lors de la prĂŠsence de loueurs de mots clefs, il reste une zone oĂš afficher les sites pertinents n'ayant rien payĂŠ !

- Il est facile d'avoir son site rĂŠfĂŠrencĂŠ par Google. Il n'y a pas de politique de filtrage manuel comme chez Yahoo en 2000.

- Les algorithmes originaux et fort peu documentĂŠs de Google assurent de meilleurs rĂŠsultats (plus pertinents) aux internautes que les autres technologies (Ă ce jour)

Les internautes aiment la qualitÊ des rÊsultats de recherche de Google : les rÊsultats sont plus pertinents que le rÊsultat de ces même recherches via annuaires. Le basculement se fait très vite. Google règne dÊsormais en maÎtre.

ConsĂŠquence : pour ne pas se faire doubler, pour protĂŠger son avance, il n'y a pas de rĂŠelles informations publiĂŠes sur le fonctionnement des algorithmes par Google. Les rĂŠfĂŠrenceurs sont donc obligĂŠs de chercher par eux-mĂŞmes, ce qui coĂťte cher. Donc cela incite chacun d'entre eux Ă protĂŠger son savoir faire. D'oĂš une raretĂŠ importante sur de l'information de qualitĂŠ pour rĂŠfĂŠrencer et surtout positionner efficacement son site.

I-A-2. Bien comprendre l'objectif central de Google▲

MĂŞme si les 2 fondateurs sont "originaux" et priment quelquefois l'idĂŠologie sur le business, globalement Google est une sociĂŠtĂŠ qui doit gĂŠnĂŠrer beaucoup de profit. Elle sera donc impitoyable avec tout obstacle sur ce chemin.

Comment un site WEB (le vĂ´tre) devient-il un obstacle sur le chemin de Google ???

- spam indexing : faire rĂŠfĂŠrencer des pages bidons qui renvoient ensuite vers le site principal

- cloaking : Google lit des pages inaccessibles aux internautes (et vice versa)

- duplicate content : un mĂŞme contenu existant dans 2 pages diffĂŠrentes.

Si votre site fait cela volontairement ou non, il sera plus ou moins sanctionnĂŠ par Google.

Pourquoi autant d'attention sur les contenus et la pollution de l'index ?

Regardez l'histoire de Google et des moteurs sur le net. Les internautes font le moteur prÊpondÊrant. Qu'ils soient dÊçus, par AltaVista puis par Yahoo!, alors massivement les internautes quittent leurs habitudes et investissent un autre outil.

L'objectif premier de Google, objectif qui passe mĂŞme devant les rĂŠsultats financiers, est de satisfaire les internautes en leur donnant des rĂŠsultats pertinents.

Polluer volontairement ou non l'index de Google plombe la crĂŠdibilitĂŠ des rĂŠsultats et peut potentiellement dĂŠgoĂťter des internautes de Google. Donc pas de quartier pour les pollueurs d'index.

I-B. Pourquoi un rĂŠfĂŠrencement ? Le changement de comportement des clients et des prospects▲

Tout type d'acheteur, entreprise ou particulier, passe dĂŠsormais par un moteur sur Internet (Google...) pour :

- Rechercher des offres alternatives Ă un prestataire en place "des fois qu'il y ait mieux ailleurs"

- Comparer les prix, les prestations, les produits avant tout achat

- Consulter le BUZZ sur une entreprise, un produit... avant tout achat

Ătre invisible sur Google ou autres moteurs c'est perdre des prospects qualifiĂŠs et ciblĂŠs. Donc du business. Demain, la valorisation d'une entreprise inclura la qualitĂŠ de son rĂŠfĂŠrencement

I-C. Pourquoi rĂŠfĂŠrencer son site en mode naturel ?▲

I-D. Initiation au rĂŠfĂŠrencement en termes simples▲

I-D-1. Ătape #1 - Mots et expressions clefs - La mission du marketeur▲

- Identifier les mots clefs du "mĂŠtier" de l'entreprise (et donc de son site WEB)

- Les tester, en rechercher d'autres, combiner, analyser

- Donc aucun trafic qualifiĂŠ

-

Profil de cette mission clef : WEB marketeur

- Des capacitĂŠs Ă analyser un marchĂŠ, les comportements, les attentes priment sur la technicitĂŠ (HTML, PHP etc.) du site.

- Donc perte de prospects

I-D-2. Ătape #2 - AccessibilitĂŠ technique & sĂŠmantique du site - Les contenus voulus - Le rĂ´le de la technique et du marketeur▲

- L'accessibilitĂŠ technique : le robot doit pouvoir accĂŠder Ă la page et Ă son contenu.

- L'accessibilitĂŠ sĂŠmantique : les bons termes destinĂŠs Ă devenir des expressions clefs Ă positionner doivent ĂŞtre efficacement mis en valeur.

RĂŠpĂŠter, "spammer", un mot dans une page n'est certainement pas efficace. Au contraire. Disperser cette expression clef partout sur le site n'est pas efficace non plus. Une accessibilitĂŠ sĂŠmantique est bien plus subtile et elle sera abordĂŠe en dĂŠtail plus avant dans ce document.

- Ătre accessible aux moteurs (un % important de sites bloquent tout ou partie des robots de Google pour cause de maladresses techniques)

- Pousser les bons mots et expressions clef au bon endroit

- Dernier exemple en date : "espace crĂŠdit" (l'expression clef rĂŠfĂŠrencĂŠe en rĂŠalitĂŠ par le site aux yeux de Google) n'a aucun rapport avec "Assurance crĂŠdit" (l'expression clef recherchĂŠe) sur le site d'un courtier en assurances.

- Ăparpiller un mot clef dans un site peut pĂŠnaliser le rĂŠfĂŠrencement du site :

- Il est nĂŠcessaire de le faire

- Mais fait sans comprendre inversera la performance. Google aura une vision brouillĂŠe de la maĂŽtrise de ce mot clef par le site et le positionnement en sera pĂŠnalisĂŠ.

- Conclusion : il faut savoir ĂŠquilibrer les contenus et donc avoir une bonne comprĂŠhension de Google.

- Ne pas tricher et faire attention Ă ce que l'on fait

- Sanctions Google : de black liste Ă Sand Box => site WEB invisible ou presque sur Google

- MaĂŽtrise, de correcte Ă excellente, des techniques du WEB (HTML, PHP, Java script, Photoshop...)

- Comprendre Google en accessibilitÊ demande du temps, du travail, des essais, du temps, de la patience, du temps, de la persÊvÊrance, du temps, de l'opiniâtretÊ, du temps, de la rÊflexion et puis encore et toujours du temps, du temps, beaucoup de temps...

- Ă 90%, comprendre les mĂŠcanismes de rĂŠfĂŠrencement de Google n'est pas compliquĂŠ. Juste long. Comprendre comment bien optimiser voire jusqu'Ă tricher sans se faire prendre exigent beaucoup de temps et de tests.

I-D-3. Ătape #3 - Ătre bien positionnĂŠ▲

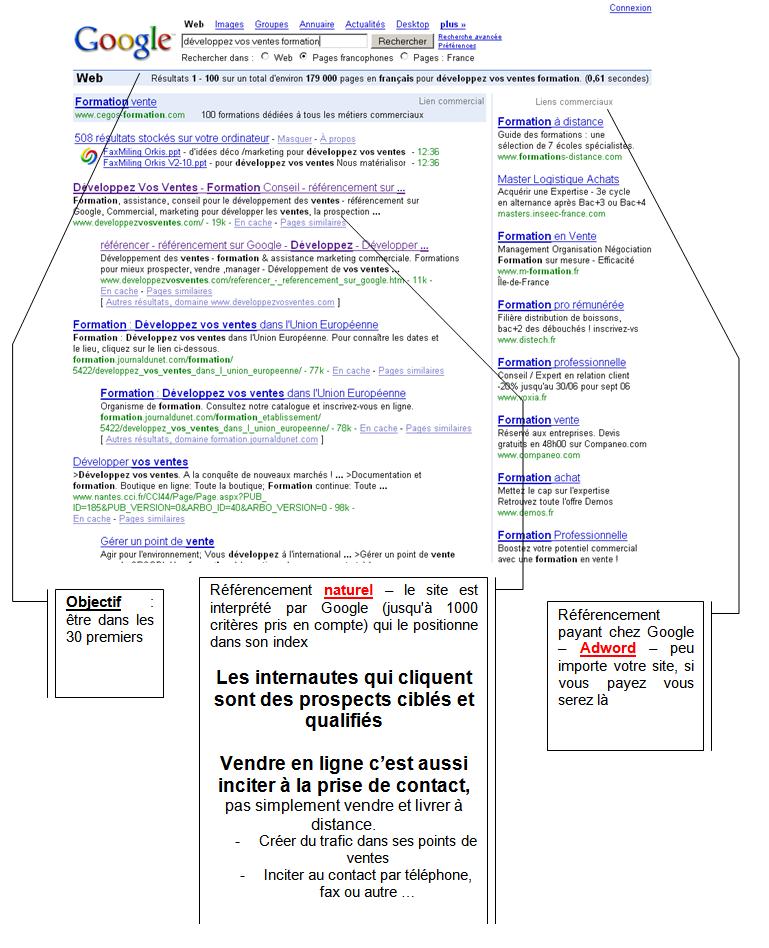

- DĂŠfinition : Ătre dans les 30 premières rĂŠponses Ă une requĂŞte correspond Ă l'expression "ĂŞtre bien positionnĂŠ"

- RĂŠfĂŠrencer son site en le modifiant pour qu'il soit accessible avec les bons mots clefs rend possible d'ĂŞtre bien positionnĂŠ "un jour" dans le futur. Pas plus ! Il n'y a aucune garantie.

- StratĂŠgique et indispensable, long, difficile...

- Techniquement simple quand on comprend Google sinon il est facile d'avoir un travail massacrĂŠ et mĂŞme contre productif

- "Petite main" : pour dĂŠmarcher les ĂŠchanges de liens

- "Traffic manager" nouveau mÊtier en cours d'apparition ; il gère les opÊrations payantes ou non pour booster le positionnement du site dont la gestion des liens.

Piège(s) : les liens dits "annuaires" - Ex : "350⏠HT l'inscription dans 5000 annuaires du net" - Une alternative un zeste "provoc" : prenez 7 billets de 50⏠et jetez-les par la fenêtre de votre bureau. Ce type de liens ne participe que fort modestement au rÊfÊrencement efficace d'un site.

I-D-4. Ătape #4 - Maintenir son rĂŠfĂŠrencement & quelques trucs▲

- Sans suivi du rĂŠfĂŠrencement, ce dernier se dĂŠgrade vite car la pression est grande sur le Net

- Un nouveau mĂŠtier va apparaĂŽtre : positionneur de site

- Ne pas se dĂŠcourager - nombre d'expressions clefs ne sont pas bien gĂŠrĂŠes, mal dĂŠfendues par les "bien positionnĂŠs" actuels - il est tout Ă fait faisable de bien se placer.

- Marketing & RÊflexions bien menÊes peuvent faire très fort rapidement en positionnement

I-E. Adwords et autres liens commerciaux versus rĂŠfĂŠrencement naturel▲

| Â | Adword - AdSense | RĂŠfĂŠrencement naturel |

|---|---|---|

| Prestataire à payer | 0⏠ou petit budget pour marketing sur mots et expressions clefs. | Budget moyen à ÊlevÊ en ⏠: analyse mots clefs, accessibilitÊ, positionnement de base |

| CoĂťt de l'exploitation | Payer Google ou Yahoo au fil des clics sur les liens commerciaux - de 20 Ă 1000 âŹmensuel voire plus | Ăventuel positionnement payant (louer de vrais et bons backlinks), suivi du rĂŠfĂŠrencement - budget largement infĂŠrieur Ă Adword ou AdSense |

| Escroquerie(s) & fraude(s) | MalgrĂŠ les efforts de Google et Yahoo, sabotage et faux clics entre concurrents ou par escrocs en ligne faussent ces outils | Si prestataires incompĂŠtent ou arnaquant le client sur la qualitĂŠ. |

| DĂŠlai | ImmĂŠdiat | De quelques jours Ă quelques semaines ou mois |

| Conclusion | Rapide mais cher si il n'y a que cela pour crÊer du trafic sur le site. Les 2 approches se complètent Gare aux arnaques dans les 2 approches |

Investissement de dĂŠpart ĂŠlevĂŠ mais plus d'efficacitĂŠ dans le temps et moins cher sur la durĂŠe |

I-F. Rappel d'ĂŠvidences▲

I-F-1. Inutile de rĂŠfĂŠrencer un site Internet touffu▲

Comment Êvaluer si votre site est acceptable ou si il doit être rÊvisÊ, retouchÊ voire même refondu complètement ? Comparez le à ses concurrents, demandez à des "prospects" rÊels ou tests leur avis et leurs raisons. Questionnez aussi un spÊcialiste.

RĂŠflĂŠchir avant d'agir, ne pas hĂŠsiter devant un budget "rĂŠflexion" et analyse pourra vous faire ĂŠconomiser du temps, de l'argent et gagner en qualitĂŠ.

I-F-2. Inutile de rĂŠfĂŠrencer des mots clefs inutilisĂŠs▲

Personne ne les trouvera ! Donc pas de visiteurs.

Nous verrons comment utiliser les outils gratuits de Google et Yahoo ! pour ĂŠvaluer approximativement un potentiel de frĂŠquentation.

Un outil de Google payant (une poignĂŠe d'euros) permet d'affiner.

I-G. DĂŠfinitions▲

I-G-1. Les termes simples▲

Google rĂŠfĂŠrence des pages HTML et non des sites !

Le rĂŠfĂŠrencement passif : c'est le travail Ă rĂŠaliser sur le site tant en mot clef qu'en modifications techniques pour rĂŠfĂŠrencer le site

Le rĂŠfĂŠrencement actif : ce sont les actions menĂŠes hors du site pour rĂŠfĂŠrencer ledit site.

le Page Rank (PR) : la dĂŠfinition fait l'objet d'un paragraphe dĂŠdiĂŠ plus loin dans le prĂŠsent document.

Un annuaire Internet fonctionne comme les "Pages Jaunes" de Wanadoo : les sites y sont classÊs par thèmes ou par ordre alphabÊtique. Une intervention humaine côtÊ annuaire est gÊnÊralement nÊcessaire pour contrôler la qualitÊ de l'inscription. Cela en explique le coÝt facturÊ par l'annuaire à l'entreprise qui s'y inscrit.

Un moteur est automatisĂŠ. Une flotte de robots logiciels (spider, Google Bot...) parcourent Internet, suivent des liens de sites en sites et ils capturent des pages, qu'ils stockent dans les espaces disques du moteur (15 000 serveurs en 2004 chez Google pour vous donner une idĂŠe) et dont ils indexent tous les mots significatifs dans une immense base de donnĂŠes centralisĂŠe.

Le positionnement traduit le fait d'être prÊsent ou non dans un rÊsultat de recherche sur mots clefs existants dans une des pages de votre site. Il traduit plus finement votre position dans la rÊponse par rapport à la 1ère rÊponse (la meilleure place bien sur). Les places qui comptent sont celles des 3 premières pages de 10 rÊponses unitaires (10 rÊponses correspond au format standard de rÊponse de Google. Ce format est bien sur modifiable par l'internaute mais c'est un autre aspect de Google)

Un cookie est un code de marquage envoyÊ par un site Internet sur votre disque dur. Ce code est unique. Si vous revenez sur le site Internet auteur du cookie, seul lui peut le lire... et vous identifier. De nombreux sites commerciaux utilisent cette technique pour donner du confort à leurs usagers, contrôler l'accès et... comprendre vos habitudes.

Un jeton de session est un genre de cookie (un code de marquage) utilisÊ comme code obligatoire d'accès à des pages du site. Cette technique est utilisÊe pour contrôler l'accès à des contenus sensibles, pour lutter contre les intrusions, pour permettre le cheminement dans des transactions financières en ligne etc.

Critères page ON : ce sont les critères de chaque page qui ont un impact sur l'aspect visuel, au sens large. L'internaute perçoit une modification d'un tel critère. Exemple : gÊrer les balises <hx></hx> (h1, h2...) pour la mise en page plutôt que du <strong></strong>.

Critères page OFF : ce sont les critères de chaque page qui n'ont AUCUN impact sur l'aspect visuel. La balise meta DESCRIPTION par exemple.

Critères ON et OFF PAGES : il y a environ 1000 critères pris en compte par Google... Tous n'ont pas le même poids bien sur. Les plus importants :

- En local : Title, Description, URL de la page, nom de fichier de la page HTML, le nombre de mots significatifs

- En Backlink : le contexte et la thĂŠmatique, la sĂŠmantique du paragraphe, de la page, du site. Le positionnement du lien BL au sein de la page et du texte. La qualitĂŠ du texte en rĂŠdactionnel.

I-G-2. Page Rank▲

I-G-2-a. Objectif recherchĂŠ▲

Google veut satisfaire ses usagers (et les fidĂŠliser par leur contentement)

Comment dĂŠtecter une page ayant un contenu et une pertinence de bonne qualitĂŠ par rapport Ă une autre moins pertinente ?

Une des (multiples) rĂŠponses consiste pour Google Ă se baser sur l'avis des internautes.

Le principe est le suivant : plus les internautes vont sur un site, plus des sites WEB mentionnent un site, alors plus ce site aura de visiteurs et donc il dispose potentiellement de contenus de qualitĂŠ susceptibles de rĂŠpondre efficacement Ă la requĂŞte d'un internaute.

- Le nombre de liens pointant vers une page Ă indexer

- La qualitĂŠ en page rank de chaque page contenant un lien pointant vers la page Ă indexer

Plus un site populaire a un lien pointant vers la page Ă indexer, plus elle communiquera un page rank ĂŠlevĂŠ Ă cette page (principe des vases communicants)

Plus il y a de sites qui ont des pages pointant vers cette page, plus le page rank sera ĂŠlevĂŠ.

VoilĂ pour la dĂŠfinition simple et l'objectif recherchĂŠ par Google.

Afin de limiter les Êchanges de liens non pertinents, Google "facture" les pages qui possèdent des liens sortants vers d'autres pages externes au site. Il retire un % de PR de la page appelante pour le transfÊrer vers la page pointÊe. (principe des vases communicants)

I-G-2-b. Une dĂŠfinition plus complète▲

Concrètement : à quoi sert le PR, pourquoi en avoir c'est mieux ?

- La rĂŠgularitĂŠ du passage de Google sur le site - vous mettez votre site Ă jour ? avec un PR ĂŠlevĂŠ les nouveautĂŠs seront prises en compte plus vite

- Le volume de pages prises en compte. Vous avez plusieurs niveaux de profondeurs dans votre arborescence ? plus le PR est ĂŠlevĂŠ, plus Google ira profond.

- Les pages dynamiques : plus vous avez de PR, plus Google accepte des pages Ă URL dynamique non "rewritĂŠ"

- Bref, avoir du contenu, de l'accessibilitĂŠ efficace et du PR conduit Ă avoir un site plus facile Ă positionner.

La base du Page Rank, notĂŠ PR dans la suite des pages de ce document, est une formule mathĂŠmatique, d'aspect complexe mais finalement simple Ă apprĂŠhender quand on en comprend les principes fondamentaux.

Comprendre le PR est important pour pouvoir amĂŠliorer son positionnement et sa visibilitĂŠ sur le net via Google et pour limiter au maximum ses propres pertes de PR pour les liens sortants de ses propres pages.

ATTENTION : l'application de cette formule comporte des exceptions non documentĂŠes par Google.

- Un site n'ayant pas de liens sortants et donc aucune fuite de PR se verra sanctionner par un fort retrait de PR. Vous ne jouez pas le jeu du WEB ni surtout le jeu de Google (si tout le monde fait pareil alors comment ferait Google pour fonctionner correctement ? Crime de lèse majestÊ !) alors forte sanction.

- Un site ayant beaucoup de liens sortants devrait voir son PR s'effondrer d'après la formule du PR. Pas du tout, au contraire ! Google ajoute un fort bonus de PR à tout site ayant de la frÊquentation et disposant de nombreux liens commentÊs et donc potentiellement informatifs de qualitÊ pour les usagers.

I-G-2-c. La formule▲

Nous assumons qu'une page A reçoit des liens (ou "votes") Êmis par les pages T1. à Tn.

Le paramètre d est un facteur d'amortissement pouvant être ajustÊ entre 0 et 1. Nous donnons gÊnÊralement à d la valeur 0.85.

De mĂŞme, C(A) est dĂŠfini comme le nombre de liens ĂŠmis par la page A, (liens sortants). Le PageRank de la page A est dĂŠfini comme suit :

PR(A) = (1-d) + d (PR(T1)/C(T1) + ... + PR(Tn)/C(Tn))

Le PageRank peut ĂŞtre calculĂŠ en utilisant un simple algorithme itĂŠratif et il correspond au vecteur propre principal de la matrice normalisĂŠe des liens du Web.

| PR(A) | Le Page Rank de la page A |

| PR(Tn) | Le Page Rank de la page Tn |

| C(Tn) | Le nombre de liens ĂŠmis depuis la page Tn |

| d | Tous les "liens entrants" sur la page A sont additionnĂŠs, mais pour en limiter l'importance, le total est multipliĂŠ par ce coefficient d'amortissement (0.85) |

| 1 - d | Un petit peu de "magie mathĂŠmatique" qui permet de garantir que la moyenne des Page Rank de l'ensemble des pages du Web sera de 1. |

L'examen de cette formule permet de voir que le PageRank d'une page n'ayant aucun lien entrant sera de 0.15.

(1 - 0.85) + 0.85*(0) = 0.15Plusieurs sites, forums pensent que l'Êchelle du Page Rank est logarithmique, sans que ceci ne soit officiellement admis par Google. Personnellement j'ai mesurÊ que oui, l'Êchelle du PR est logarithmique. La base utilisÊe est estimÊe. Il est probable que cette base Êvolue dans le temps. Plus complexe encore, je soupçonne que la base de log ne soit pas la même tout le long de la courbe. Mais bon, restons sur l'hypothèse que la base de log est stable pour simplifier la comprÊhension de ce mÊcanisme.

Prenons une ĂŠchelle logarithmique de base 10 pour simplifier nos calculs et pour bien illustrer notre propos.

La communautĂŠ des rĂŠfĂŠrenceurs ĂŠtudiant Google estime qu'actuellement, la base de log utilisĂŠe oscille dans la plage 5 Ă 8. Notre exemple de 10, rappelons le, permet de simplifier le cours. Il n'est d'ailleurs pas exclus que Google ne passe un jour Ă la valeur 10 devant l'augmentation continue du nombre de sites et de pages Ă indexer.

| PageRank AffichĂŠ (log base 10) | PageRank rĂŠel (calculĂŠ) |

|---|---|

| PR0 | 0 <= PR < 1 |

| PR1 | 1 <= PR < 10 |

| PR2 | 10 <= PR < 100 |

| PR3 | 100 <= PR < 1000 |

| PR4 | 1000 <= PR < 10000 |

Chaque niveau de Page Rank est 10 fois plus ĂŠlevĂŠ que le niveau prĂŠcĂŠdent. En clair il est 10 fois plus ardu de passer de PR4 Ă PR5 que de passer de PR3 Ă PR4.

Une première consÊquence de cette formule : si un site n'Êvolue pas, son PR se dÊgrade au fil du temps. En effet, le nombre de pages, de sites augmentant continuellement, le nombre de liens C(Tn) augmentent et le PR transfÊrÊ diminue.

Chaque fois que la base augmente pour faire face Ă la quantitĂŠ de pages Ă indexer, la plage de chaque PR augmente et tend Ă faire diminuer le PR des pages d'un site non maintenu Ă jour.

Une autre consĂŠquence de cette formule : elle tend Ă faire converger le PR moyen d'une page vers UN.

La manière dont Google a prÊsentÊ cette formule indique qu'il n'est pas nÊcessaire de disposer de tous les PR des pages. En itÊrant la formule, le calcul converge vers la valeur finale. Bref, cela ne consomme pas de ressources si importantes.

I-G-3. Important, ne pas confondre PageRank et positionnement !▲

Un bon page Rank, c'est-à -dire une bonne popularitÊ d'après Google de votre site n'est pas l'assurance d'être bien positionnÊ en rÊsultats de recherche.

Certes un bon page Rank aide à avoir un bon positionnement mais il est très facile d'avoir un site de page Rank 1 ou 2 et d'être mieux positionnÊ sur des mots clefs qu'un site de page Rank 4 ou 5. mal gÊrÊ sur ces même mots clefs.

Pourquoi ? Parce que Google veut publier des rĂŠsultats pertinents Ă ses internautes et les sites Ă fort pouvoirs financiers sont ainsi limitĂŠs en efficacitĂŠ de l'argent face Ă la qualitĂŠ. des contenus.

Comment ? en travaillant bien la sĂŠmantique puis quelques backlinks, un site Ă petits moyens financiers pourra ĂŞtre mieux positionnĂŠ qu'un site disposant d'un budget rĂŠfĂŠrencement (et donc des moyens d'obtention d'un bon page rank) mais relativement pauvre en contenu ou mal gĂŠrĂŠ en accessibilitĂŠ (technique ou sĂŠmantique)

Conclusion : le rĂŠdactionnel prime sur les astuces techniques. Mais sans une bonne accessibilitĂŠ, le rĂŠdactionnel, le contenu aura beaucoup de mal Ă ĂŠmerger.